Coeficiente Kappa:

La Calculadora de coeficiente Kappa es una herramienta valiosa que se utiliza en diversos campos, incluidos statistics, estudios de confiabilidad entre evaluadores y metodologías de investigación. Esta calculadora ayuda a determinar el acuerdo entre dos o más evaluadores más allá de lo que se esperaría por casualidad. Básicamente, mide el nivel de acuerdo entre observadores o evaluadores al evaluar elementos categóricos.

Calculadora de fórmula del coeficiente Kappa

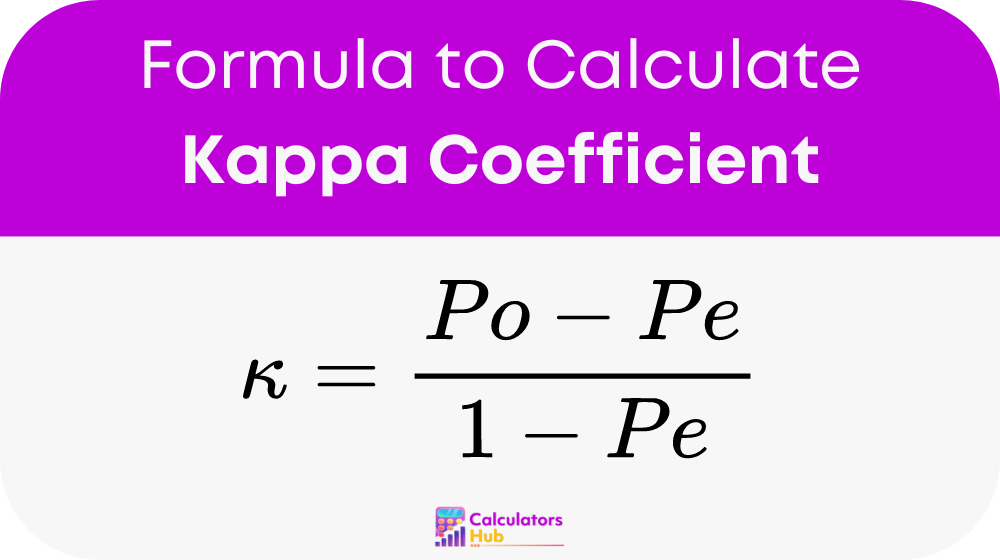

El coeficiente Kappa (κ) se calcula mediante la siguiente fórmula:

Lugar:

- Po: Representa el acuerdo relativo observado entre los evaluadores.

- Pe: Denota la probabilidad hipotética de acuerdo casual.

Calcular Po:

- Determine la proporción de acuerdo observado entre los evaluadores.

Calcular Pe:

- Calcule el acuerdo esperado por azar, con base en las probabilidades marginales de las categorías de cada evaluador.

Una vez que tenga valores para Po y Pe, conéctelos a la fórmula para encontrar el kappa de Cohen.

Tabla de Términos Generales

| Acuerdo observado (Po) | Acuerdo esperado (Pe) | Coeficiente Kappa (κ) |

|---|---|---|

| 0.1 | 0.1 | 0.000 |

| 0.2 | 0.1 | 0.167 |

| 0.3 | 0.1 | 0.333 |

| 0.4 | 0.1 | 0.500 |

| 0.5 | 0.1 | 0.667 |

| 0.6 | 0.1 | 0.800 |

| 0.7 | 0.1 | 0.857 |

| 0.8 | 0.1 | 0.889 |

| 0.9 | 0.1 | 0.909 |

| 0.1 | 0.2 | -0.111 |

| 0.2 | 0.2 | 0.000 |

| 0.3 | 0.2 | 0.125 |

| 0.4 | 0.2 | 0.250 |

| 0.5 | 0.2 | 0.375 |

| 0.6 | 0.2 | 0.500 |

| 0.7 | 0.2 | 0.571 |

| 0.8 | 0.2 | 0.600 |

| 0.9 | 0.2 | 0.625 |

Ejemplo de calculadora de coeficiente Kappa

El Dr. Smith y el Dr. Johnson diagnostican de forma independiente a los pacientes para una enfermedad. De 100 pacientes coinciden en 80 diagnósticos.

- Acuerdo observado (Po): 80/100 = 0.8

- Acuerdo esperado (Pe): Suponiendo un acuerdo de probabilidad basado en la prevalencia de la enfermedad, digamos 30/100 = 0.3

Usando la fórmula del coeficiente Kappa: κ = (0.8 – 0.3) / (1 – 0.3) ≈ 0.7143

Resultado: El coeficiente Kappa (κ) indica un nivel sustancial de acuerdo entre los dos médicos más allá del azar, lo que sugiere una consistencia diagnóstica confiable.

Preguntas frecuentes más comunes

El coeficiente Kappa mide el nivel de acuerdo entre dos o más evaluadores más allá de lo que se esperaría únicamente por casualidad. Se utiliza comúnmente en estudios de confiabilidad entre evaluadores para evaluar la consistencia de juicios categóricos o medidas.

La interpretación del Coeficiente Kappa varía según su valor. Un valor de 1 indica un acuerdo perfecto, 0 indica un acuerdo equivalente al azar y los valores negativos sugieren un acuerdo peor que el azar. Generalmente, valores superiores a 0.75 indican un acuerdo excelente, mientras que valores inferiores a 0.4 sugieren un acuerdo deficiente.

Varios factores pueden influir en el coeficiente Kappa, incluida la complejidad de la tarea de calificación, el número de evaluadores y la prevalencia de las categorías que se califican. Además, las discrepancias en la capacitación de los evaluadores o en la comprensión de los criterios de calificación pueden afectar los niveles de acuerdo.