这种专门的工具通过提供评估者之间超越偶然的一致性的标准化衡量标准来帮助研究人员和统计学家。它在心理学、医学和任何涉及观察数据的研究领域特别有用。

评估者间可靠性计算器的公式

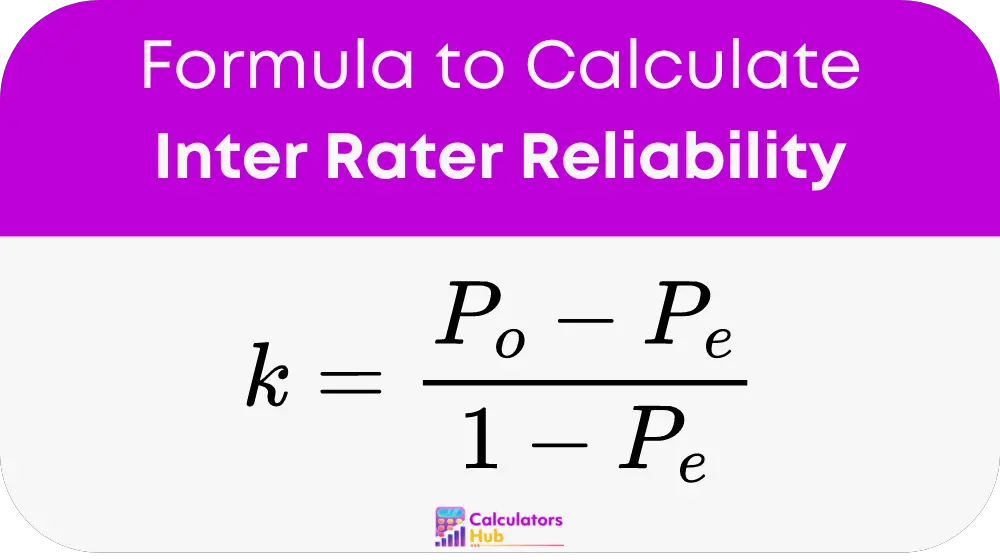

- 键 用于衡量评估者间可靠性的公式是 Cohen 的 Kappa (k),它量化了两个评估者之间的一致性程度。公式为:

地点:

- P_o 是评估者之间观察到的一致性。

- P_e 是偶然的预期一致。

使用评估者间可靠性计算器的分步指南

构建列联表:

创建一个表来记录两个评分者分配的不同评分。例如:

| 评估者B:是的 | 评估者 B:否 | |

|---|---|---|

| 评估者A:是的 | a | b |

| 评估者 A:否 | c | d |

计算观察到的一致性 (P_o):

P_o = (a + d) / (a + b + c + d)

计算预期一致性 (P_e):

P_e = ((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2

计算 Cohen 的 Kappa:

使用上面的值代入 Cohen's Kappa 公式以获得结果。

一般术语及相关计算表

| 按揭年数 | 定义 |

|---|---|

| 评估者间的可靠性 | 衡量不同评估者评估相同现象的一致性的指标。 |

| 科恩的 Kappa (k) | 衡量分类项目的评估者间可靠性的统计数据。 |

| 遵守的协议 (P_o) | 评估者同意的次数比例。 |

| 预期协议 (P_e) | 评估者偶然同意的概率。 |

| 列联表 | 用于计算评估者之间的同意和分歧的矩阵。 |

该表提供了快速参考,以了解评估评估者间可靠性时使用的关键术语和计算,有助于理解可靠性计算器的方法。

评估者间可靠性计算器示例

场景:

两名心理学家正在评估一组患者的特定心理状况,他们必须将每位患者分类为“高风险”或“低风险”。在评估了 10 名患者后,他们将评估结果记录如下:

- 评估者 A:高风险:5 名患者,低风险:5 名患者

- 评估者 B:高风险:4 名患者,低风险:6 名患者

他们的评价具体是:

| 患者编号 | 评估者 A 评估 | 评估者 B 评估 |

|---|---|---|

| 1 | 高风险 | 高风险 |

| 2 | 低风险 | 低风险 |

| 3 | 高风险 | 低风险 |

| 4 | 低风险 | 低风险 |

| 5 | 高风险 | 高风险 |

| 6 | 低风险 | 高风险 |

| 7 | 高风险 | 高风险 |

| 8 | 低风险 | 低风险 |

| 9 | 高风险 | 低风险 |

| 10 | 低风险 | 低风险 |

计算:

构建列联表:

| 评估者 B:高风险 | 评估者 B:低风险 | |

|---|---|---|

| 评估者 A:高风险 | 3(一) | 2(二) |

| 评级者 A:低风险 | 1(c) | 4(d) |

计算观察到的一致性 (P_o):

P_o = (a + d) / (a + b + c + d) = (3 + 4) / 10 = 0.7

计算预期一致性 (P_e):

P_e = [((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2]

= [((3 + 2) * (3 + 1) + (1 + 4) * (2 + 4)) / 10^2]

= [20 + 30] / 100 = 0.5

计算 Cohen 的 Kappa:

k = (P_o – P_e) / (1 – P_e) = (0.7 – 0.5) / (1 – 0.5) = 0.4

Cohen 的 Kappa 值为 0.4,这表明两个评估者之间存在适度的一致性,超出了偶然性。

最常见的常见问题解答

它衡量不同评估者之间的一致性,确保不同观察者的评估保持一致。

Cohen 的 Kappa 认为一致性是偶然发生的,提供了比简单百分比一致性更准确的可靠性度量。