贝尔曼方程计算器是一种专门的工具,用于计算动态规划环境中决策过程的最优值。它最常用于强化学习、经济学和运筹学领域。贝尔曼方程本身是一个 递归 公式将复杂的决策问题分解为更简单的子问题,从而计算出给定状态下的最大可能回报。该方程构成了许多用于解决马尔可夫决策过程 (MDP) 的算法的基础,这些模型用于描述结果部分随机、部分受决策者控制的系统。

该计算器通过自动执行必要的计算简化了寻找最佳策略的过程。通过输入相关参数(例如奖励函数、转移概率和折扣因子),用户可以快速确定给定状态的值,从而决定在该状态下应采取的最佳行动。对于在各个领域处理优化问题的人来说,此工具非常有价值,使他们能够做出更明智和更具战略性的决策。

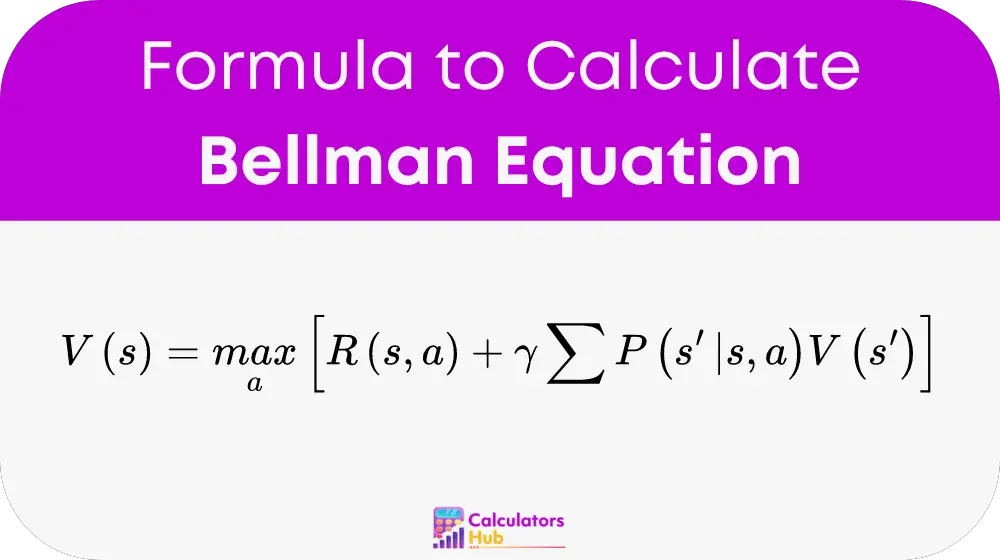

贝尔曼方程计算器公式

贝尔曼方程表示为:

地点:

- V(s)是状态s的值。

- max_a 表示在所有可能的动作 a 中取最大值。

- R(s, a) 是在状态 s 下采取行动 a 的直接奖励。

- γ 是折扣因子,它决定了未来奖励的重要性。

- Σ 表示所有可能的下一个状态 s' 的总和。

- P(s'|s, a) 是采取行动 a 后从状态 s 转换到状态 s' 的概率。

- V(s') 是下一个状态 s' 的值。

该公式是动态规划的核心,用于确定价值函数,这在结果不确定的决策过程中至关重要。

有用的换算表

对于那些经常 工作 借助动态规划和贝尔曼方程,下表提供了常用术语和转换的快速参考值。这可以节省 次 并提高使用贝尔曼方程计算器时的准确性。

| 按揭年数 | 描述 | 共同价值观 |

|---|---|---|

| 折扣因子 (γ) | 确定未来奖励与即时奖励相比的估价方式。 | 0.9,0.95,0.99 |

| 立即奖励(R) | 在特定状态下采取行动后获得的奖励。 | 根据具体情况而变化 |

| 转移概率(P) | 执行某个操作后从一种状态转变为另一种状态的可能性。 | 0.1,0.5,0.9 |

| 国家价值(V) | 处于特定状态的长期价值。 | 使用公式计算 |

这些值通常用于贝尔曼方程的各种应用,并且随时可用它们可以大大提高效率。

贝尔曼方程计算器示例

考虑这样一种场景:代理需要在特定状态下在两个动作之间做出决定。转换到新状态的直接奖励和概率如下:

- 动作 A:立即奖励 = 10,以概率 1 转换到状态 0.7,以概率 2 转换到状态 0.3

- 动作 B:立即奖励 = 5,以概率 1 转换到状态 0.4,以概率 2 转换到状态 0.6

- 折扣因子(γ)= 0.95

- 状态 1 的值 (V1) = 50

- 状态 2 的值 (V2) = 30

使用贝尔曼方程:

- 对于动作 A:V(s) = 10 + 0.95 * [0.7 * 50 + 0.3 * 30] = 10 + 0.95 * [35 + 9] = 10 + 41.8 = 51.8

- 对于行动 B:V(s) = 5 + 0.95 * [0.4 * 50 + 0.6 * 30] = 5 + 0.95 * [20 + 18] = 5 + 36.1 = 41.1

本例中,动作A的值(51.8)比动作B的值(41.1)高,说明动作A是本场景下的最佳选择。

最常见的常见问题解答

贝尔曼方程用于确定决策过程中的最佳策略,其中结果部分是随机的,部分是在决策者的控制之下。它是动态规划和强化学习的基础。

折扣因子 (γ) 决定了未来奖励相对于即时奖励的重要性。折扣因子越高,未来奖励越有价值,而折扣因子越低,即时奖励越有价值。

是的,贝尔曼方程广泛应用于经济学、机器人技术和人工智能等领域,以优化结果不确定环境中的决策过程。