Os Cohen Coeficiente Kappa A calculadora é uma ferramenta estatística usada para medir o nível de concordância entre dois avaliadores ou observadores, ao mesmo tempo em que considera a possibilidade de concordância ocorrer por acaso. É particularmente útil em cenários onde julgamentos subjetivos são feitos, como em avaliações psicológicas, classificação de conteúdo ou diagnósticos médicos. Ao contrário de uma concordância de porcentagem simples, o Kappa de Cohen ajusta para chance aleatória, fornecendo uma medida mais precisa de confiabilidade entre avaliadores. Esta calculadora pertence à categoria de calculadoras de confiabilidade estatística, auxiliando pesquisadores, estatísticos e profissionais na avaliação da consistência e validade de dados categóricos.

Calculadora da fórmula do coeficiente Kappa de Cohen

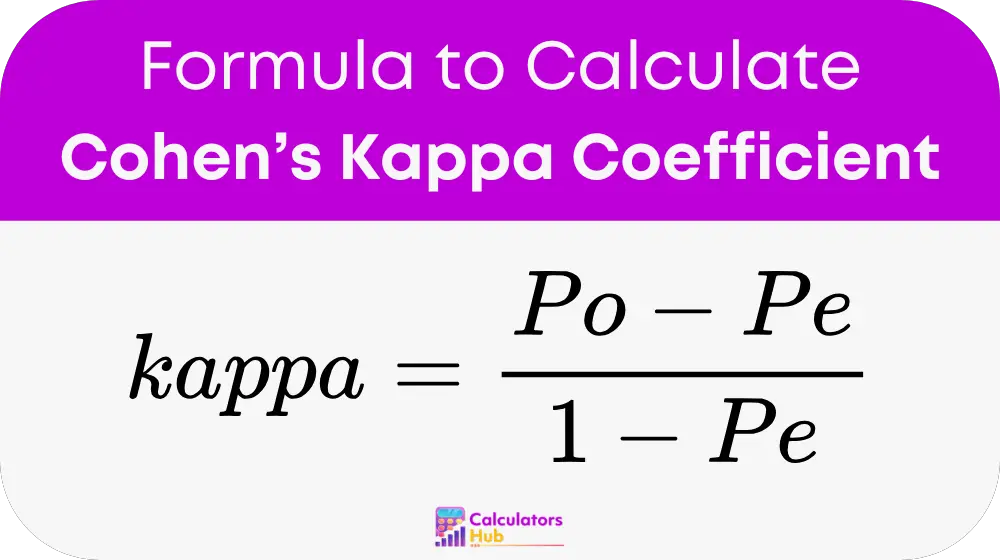

O Kappa de Cohen é calculado usando a fórmula:

Onde:

- Po é a proporção observada de concordância entre os avaliadores.

- Pe é a proporção esperada de concordância por acaso.

Fórmulas detalhadas:

Acordo Observado (Po):

Po = Número de acordos / Observações totais

Acordo Esperado (Pe):

Pe = Σ (PAi × PBi)

Onde:

- PAi é a proporção de vezes que o Avaliador A usou a categoria i, calculada como: Número de vezes que o Avaliador A usou a categoria i / Total de Observações.

- PBi é a proporção de vezes que o Avaliador B usou a categoria i, calculada de forma semelhante.

Esses cálculos garantem que o resultado leve em conta o acordo casual, fornecendo uma métrica robusta de confiabilidade.

Tabela pré-calculada para cenários Kappa de Cohen

Abaixo está uma tabela útil resumindo os valores de Kappa de Cohen pré-calculados para cenários comumente encontrados, facilitando a interpretação dos resultados sem computação manual:

| Acordo Observado (Po) | Acordo Esperado (Pe) | Kappa de Cohen (κ) | Interpretação |

|---|---|---|---|

| 0.90 | 0.50 | 0.80 | Acordo quase perfeito |

| 0.75 | 0.25 | 0.67 | Acordo substancial |

| 0.60 | 0.30 | 0.43 | Acordo moderado |

| 0.50 | 0.40 | 0.17 | Ligeiro acordo |

| 0.30 | 0.20 | 0.13 | Ligeiro acordo |

| 0.20 | 0.10 | 0.11 | Pobre acordo |

Esta tabela pode orientar os usuários a entender rapidamente os níveis de confiabilidade sem realizar cálculos detalhados.

Exemplo de calculadora do coeficiente Kappa de Cohen

Vamos considerar um exemplo. Suponha que dois avaliadores médicos avaliem a presença de uma doença em 100 pacientes. Seus resultados são:

- Avaliador A: Doença detectada em 60 pacientes, ausente em 40.

- Avaliador B: Doença detectada em 55 pacientes, ausente em 45.

Dos 100 pacientes, ambos os avaliadores concordaram com 80 (45 com doença presente, 35 ausentes).

Etapa 1: Calcular a concordância observada (Po)

Po = Número de acordos / Observações totais

Po = 80 / 100 = 0.80

Etapa 2: Calcular a concordância esperada (Pe)

A proporção para cada avaliador em cada categoria:

- PA (Doença presente) = 60/100 = 0.60, PA (Doença ausente) = 40/100 = 0.40

- PB (Doença presente) = 55/100 = 0.55, PB (Doença ausente) = 45/100 = 0.45

Pe = (0.60 × 0.55) + (0.40 × 0.45) = 0.33 + 0.18 = 0.51

Etapa 3: Calcular Kappa

Kappa = (Po - Pe) / (1 - Pe)

Kappa = (0.80 - 0.51) / (1 - 0.51) = 0.29 / 0.49 ≈ 0.59

Este valor kappa indica concordância moderada entre os avaliadores.

Perguntas frequentes mais comuns

Um valor kappa de 0.60 a 0.80 indica concordância substancial, enquanto valores acima de 0.80 representam concordância quase perfeita. Valores abaixo de 0.20 sugerem concordância ruim.

O Kappa de Cohen leva em conta a possibilidade de concordância ocorrer por acaso, tornando-se uma medida mais confiável do que a simples concordância percentual.

Não, o Kappa de Cohen é projetado para dois avaliadores. Para mais de dois avaliadores, outras medidas como o Kappa de Fleiss são usadas.