Coeficiente Kappa:

A Calculadora do Coeficiente Kappa é uma ferramenta valiosa usada em vários campos, incluindo estatística, estudos de confiabilidade entre avaliadores e metodologias de pesquisa. Esta calculadora ajuda a determinar a concordância entre dois ou mais avaliadores além do que seria esperado pelo acaso. Essencialmente, mede o nível de concordância entre observadores ou avaliadores ao avaliar itens categóricos.

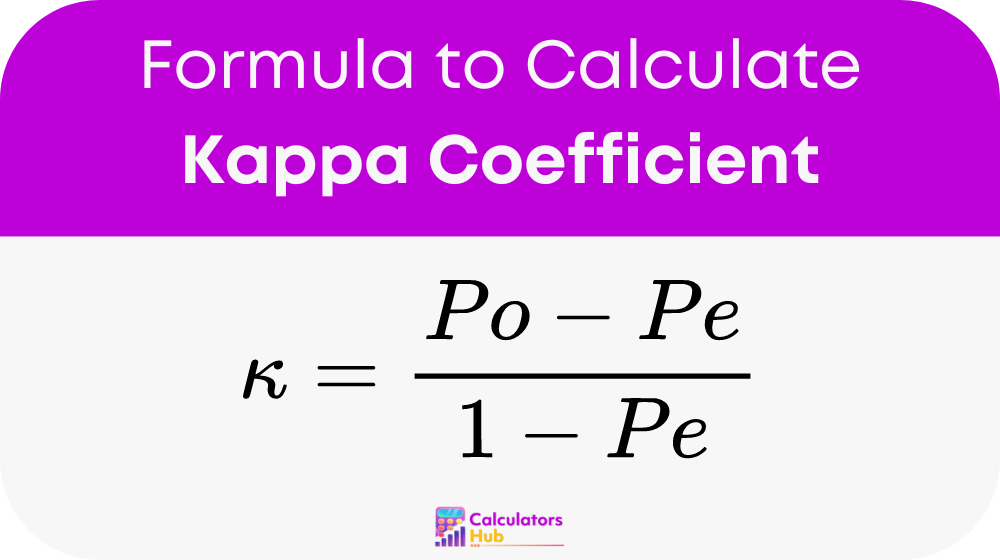

Fórmula da Calculadora do Coeficiente Kappa

O Coeficiente Kappa (κ) é calculado usando a seguinte fórmula:

Onde:

- Po: Representa a concordância relativa observada entre os avaliadores.

- Pe: Denota a probabilidade hipotética de concordância casual.

Calcular Po:

- Determine a proporção de concordância observada entre os avaliadores.

Calcular Pe:

- Calcule a concordância esperada ao acaso, com base nas probabilidades marginais das categorias de cada avaliador.

Depois de ter valores para Po e Pe, insira-os na fórmula para encontrar o kappa de Cohen.

Tabela de Termos Gerais

| Acordo Observado (Po) | Acordo Esperado (Pe) | Coeficiente Kappa (κ) |

|---|---|---|

| 0.1 | 0.1 | 0.000 |

| 0.2 | 0.1 | 0.167 |

| 0.3 | 0.1 | 0.333 |

| 0.4 | 0.1 | 0.500 |

| 0.5 | 0.1 | 0.667 |

| 0.6 | 0.1 | 0.800 |

| 0.7 | 0.1 | 0.857 |

| 0.8 | 0.1 | 0.889 |

| 0.9 | 0.1 | 0.909 |

| 0.1 | 0.2 | -0.111 |

| 0.2 | 0.2 | 0.000 |

| 0.3 | 0.2 | 0.125 |

| 0.4 | 0.2 | 0.250 |

| 0.5 | 0.2 | 0.375 |

| 0.6 | 0.2 | 0.500 |

| 0.7 | 0.2 | 0.571 |

| 0.8 | 0.2 | 0.600 |

| 0.9 | 0.2 | 0.625 |

Exemplo de calculadora de coeficiente Kappa

Smith e Dr. Johnson diagnosticam independentemente uma doença nos pacientes. Em cada 100 pacientes, eles concordam em 80 diagnósticos.

- Acordo Observado (Po): 80/100 = 0.8

- Acordo Esperado (Pe): Assumindo uma concordância casual com base na prevalência da doença, digamos 30/100 = 0.3

Usando a fórmula do Coeficiente Kappa: κ = (0.8 – 0.3) / (1 – 0.3) ≈ 0.7143

Resultado: O Coeficiente Kappa (κ) indica um nível substancial de concordância entre os dois médicos além do acaso, sugerindo consistência diagnóstica confiável.

Perguntas frequentes mais comuns

O Coeficiente Kappa mede o nível de concordância entre dois ou mais avaliadores além do que seria esperado apenas pelo acaso. É comumente usado em estudos de confiabilidade entre avaliadores para avaliar a consistência de julgamentos categóricos ou medições.

A interpretação do Coeficiente Kappa varia em função do seu valor. Um valor de 1 indica concordância perfeita, 0 indica concordância equivalente ao acaso e valores negativos sugerem concordância pior que o acaso. Geralmente, valores acima de 0.75 indicam concordância excelente, enquanto valores abaixo de 0.4 sugerem concordância ruim.

Vários fatores podem influenciar o Coeficiente Kappa, incluindo a complexidade da tarefa de classificação, o número de avaliadores e a prevalência das categorias avaliadas. Além disso, discrepâncias no treinamento dos avaliadores ou na compreensão dos critérios de classificação podem afetar os níveis de concordância.