Questo strumento specializzato aiuta ricercatori e statistici fornendo una misura standardizzata di accordo tra valutatori oltre ogni possibilità. È particolarmente utile in campi come la psicologia, la medicina e qualsiasi ricerca che coinvolga dati osservativi.

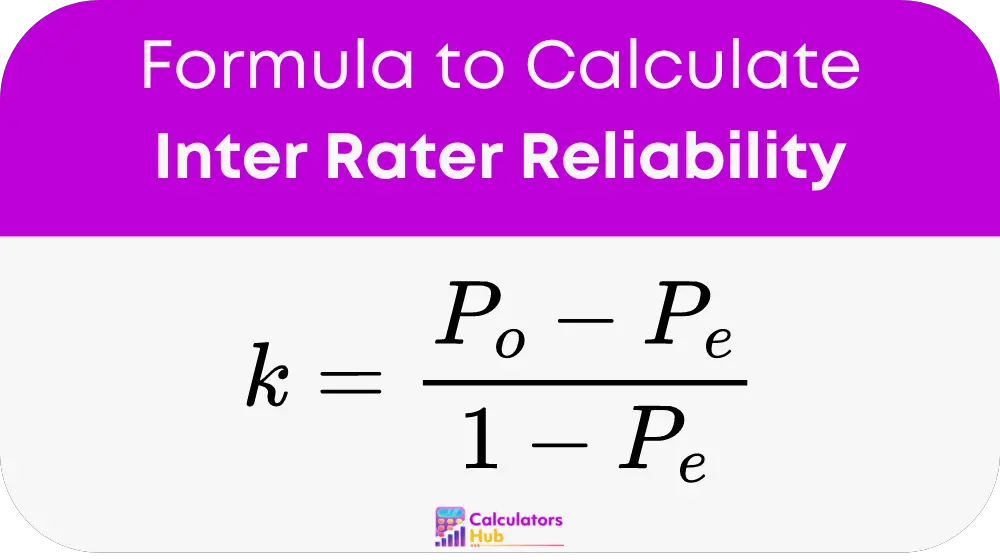

Formula del calcolatore di affidabilità Inter Rater

chiave La formula utilizzata per misurare l'affidabilità tra valutatori è la Kappa di Cohen (k), che quantifica il livello di accordo tra due valutatori. La formula è:

Dove:

- P_o è l'accordo osservato tra i valutatori.

- P_e è l'accordo atteso per caso.

Guida passo passo all'utilizzo del calcolatore di affidabilità Inter Rater

Costruisci una tabella di contingenza:

Crea una tabella per registrare diverse valutazioni assegnate da due valutatori. Per esempio:

| Valutatore B: Sì | Valutatore B: no | |

|---|---|---|

| Valutatore A: Sì | a | b |

| Valutatore A: No | c | d |

Calcolare l'accordo osservato (P_o):

P_o = (a + d) / (a + b + c + d)

Calcola l'accordo previsto (P_e):

P_e = ((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2

Calcolare la Kappa di Cohen:

Utilizzando i valori di cui sopra, sostituirli nella formula Kappa di Cohen per ottenere il risultato.

Tabella delle condizioni generali e dei relativi calcoli

| Termine | Definizione |

|---|---|

| Affidabilità tra valutatori | Una misura di quanto valutatori diversi valutano costantemente gli stessi fenomeni. |

| Kappa di Cohen (k) | Una statistica che misura l'affidabilità tra valutatori per gli elementi categoriali. |

| Accordo rispettato (P_o) | La percentuale di volte in cui i valutatori sono d'accordo. |

| Accordo previsto (P_e) | La probabilità che i valutatori siano d'accordo per caso. |

| Tabella di contingenza | Una matrice utilizzata per calcolare gli accordi e i disaccordi tra i valutatori. |

Questa tabella fornisce un riferimento rapido per comprendere i termini chiave e i calcoli utilizzati nella valutazione dell'affidabilità tra valutatori, aiutando a comprendere l'approccio metodologico del calcolatore di affidabilità.

Esempio di calcolatore di affidabilità tra valutatori

Scenario:

Due psicologi stanno valutando un gruppo di pazienti per una specifica condizione psicologica, dove devono classificare ciascun paziente come "ad alto rischio" o "a basso rischio". Dopo aver valutato 10 pazienti, hanno registrato le loro valutazioni come segue:

- Valutatore A: Alto rischio: 5 pazienti, Basso rischio: 5 pazienti

- Valutatore B: Alto rischio: 4 pazienti, Basso rischio: 6 pazienti

Le loro valutazioni riguardano nello specifico:

| ID paziente | Valutatore A Valutazione | Valutazione del valutatore B |

|---|---|---|

| 1 | Ad alto rischio | Ad alto rischio |

| 2 | A basso rischio | A basso rischio |

| 3 | Ad alto rischio | A basso rischio |

| 4 | A basso rischio | A basso rischio |

| 5 | Ad alto rischio | Ad alto rischio |

| 6 | A basso rischio | Ad alto rischio |

| 7 | Ad alto rischio | Ad alto rischio |

| 8 | A basso rischio | A basso rischio |

| 9 | Ad alto rischio | A basso rischio |

| 10 | A basso rischio | A basso rischio |

calcoli:

Costruisci una tabella di contingenza:

| Grado B: rischio elevato | Valutazione B: rischio basso | |

|---|---|---|

| Grado A: rischio elevato | 3 (a) | 2 (b) |

| Valutazione A: rischio basso | 1 c) | 4(d) |

Calcolare l'accordo osservato (P_o):

P_o = (a + d) / (a + b + c + d) = (3 + 4) / 10 = 0.7

Calcola l'accordo previsto (P_e):

P_e = [((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2]

= [((3 + 2) * (3 + 1) + (1 + 4) * (2 + 4)) / 10^2]

= [20 + 30] / 100 = 0.5

Calcolare la Kappa di Cohen:

k = (P_o – P_e) / (1 – P_e) = (0.7 – 0.5) / (1 – 0.5) = 0.4

Questo valore Kappa di Cohen pari a 0.4 suggerisce un accordo moderato oltre ogni possibilità tra i due valutatori.

Domande frequenti più comuni

Misura l’accordo tra diversi valutatori, garantendo che le valutazioni siano coerenti tra diversi osservatori.

Il Kappa di Cohen considera l'accordo avvenuto per caso, fornendo una misura di affidabilità più accurata rispetto al semplice accordo percentuale.