Coefficient Kappa :

Le calculateur de coefficient Kappa est un outil précieux utilisé dans divers domaines, notamment statistiques, études de fiabilité inter-évaluateurs et méthodologies de recherche. Cette calculatrice permet de déterminer l'accord entre deux ou plusieurs évaluateurs au-delà de ce à quoi on pourrait s'attendre par hasard. Essentiellement, il mesure le niveau d’accord entre les observateurs ou les évaluateurs lors de l’évaluation des éléments catégoriels.

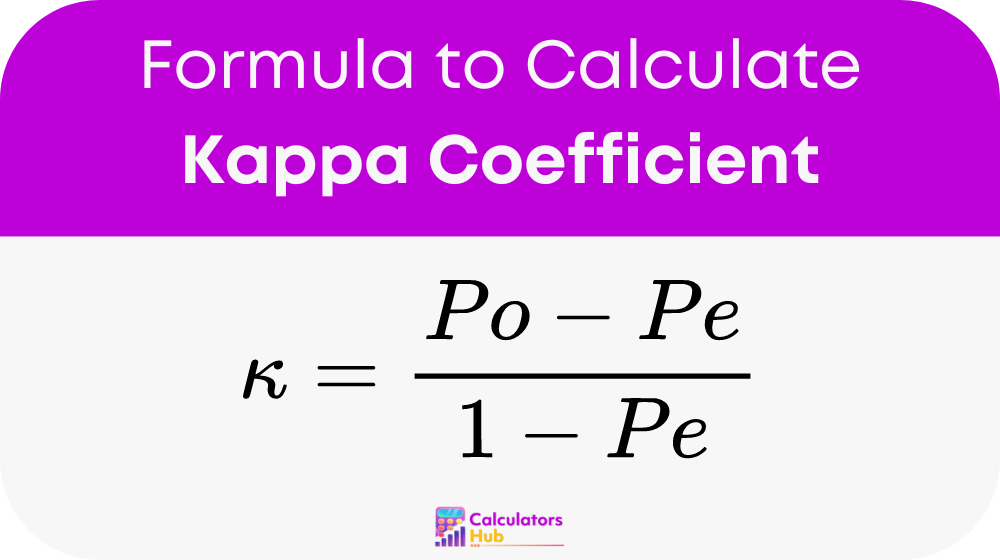

Formule du calculateur de coefficient Kappa

Le coefficient Kappa (κ) est calculé à l'aide de la formule suivante :

Où? :

- Po: Représente l’accord relatif observé parmi les évaluateurs.

- Pe: Désigne la probabilité hypothétique d’un accord fortuit.

Calculer Po:

- Déterminez la proportion d’accord observé parmi les évaluateurs.

Calculer Pe:

- Calculez l'accord attendu par hasard, sur la base des probabilités marginales des catégories de chaque évaluateur.

Une fois que vous avez des valeurs pour Po ou Pe, branchez-les dans la formule pour trouver le kappa de Cohen.

Tableau des Conditions Générales

| Accord observé (Po) | Accord attendu (Pe) | Coefficient Kappa (κ) |

|---|---|---|

| 0.1 | 0.1 | 0.000 |

| 0.2 | 0.1 | 0.167 |

| 0.3 | 0.1 | 0.333 |

| 0.4 | 0.1 | 0.500 |

| 0.5 | 0.1 | 0.667 |

| 0.6 | 0.1 | 0.800 |

| 0.7 | 0.1 | 0.857 |

| 0.8 | 0.1 | 0.889 |

| 0.9 | 0.1 | 0.909 |

| 0.1 | 0.2 | - 0.111 |

| 0.2 | 0.2 | 0.000 |

| 0.3 | 0.2 | 0.125 |

| 0.4 | 0.2 | 0.250 |

| 0.5 | 0.2 | 0.375 |

| 0.6 | 0.2 | 0.500 |

| 0.7 | 0.2 | 0.571 |

| 0.8 | 0.2 | 0.600 |

| 0.9 | 0.2 | 0.625 |

Exemple de calculateur de coefficient Kappa

Le Dr Smith et le Dr Johnson diagnostiquent indépendamment une maladie chez les patients. Sur 100 patients, ils s’accordent sur 80 diagnostics.

- Accord observé (Po): 80/100 = 0.8

- Accord attendu (Pe): En supposant un accord aléatoire basé sur la prévalence de la maladie, disons 30/100 = 0.3

En utilisant la formule du coefficient Kappa : κ = (0.8 – 0.3) / (1 – 0.3) ≈ 0.7143

Résultat : Le coefficient Kappa (κ) indique un niveau d'accord substantiel entre les deux médecins au-delà du hasard, suggérant une cohérence diagnostique fiable.

FAQ les plus courantes

Le coefficient Kappa mesure le niveau d'accord entre deux ou plusieurs évaluateurs au-delà de ce à quoi on pourrait s'attendre par le seul hasard. Il est couramment utilisé dans les études de fiabilité inter-évaluateurs pour évaluer la cohérence des jugements catégoriques ou des mesures.

L'interprétation du coefficient Kappa varie en fonction de sa valeur. Une valeur de 1 indique un accord parfait, 0 indique un accord équivalent au hasard et des valeurs négatives suggèrent un accord pire que le hasard. Généralement, les valeurs supérieures à 0.75 indiquent un excellent accord, tandis que les valeurs inférieures à 0.4 suggèrent un mauvais accord.

Plusieurs facteurs peuvent influencer le coefficient Kappa, notamment la complexité de la tâche d'évaluation, le nombre d'évaluateurs et la prévalence des catégories évaluées. De plus, les divergences dans la formation des évaluateurs ou dans la compréhension des critères de notation peuvent affecter les niveaux d’accord.