Los Cohen Coeficiente Kappa Calculator es una herramienta estadística que se utiliza para medir el nivel de acuerdo entre dos evaluadores u observadores, teniendo en cuenta la posibilidad de que el acuerdo se produzca por casualidad. Es especialmente útil en situaciones en las que se realizan juicios subjetivos, como en evaluaciones psicológicas, clasificación de contenido o diagnósticos médicos. A diferencia de un simple acuerdo porcentual, el índice Kappa de Cohen se ajusta al azar, lo que proporciona una medida más precisa de la fiabilidad entre evaluadores. Esta calculadora pertenece a la Categoría de calculadoras de confiabilidad estadística, ayudando a investigadores, estadísticos y profesionales a evaluar la consistencia y validez de datos categóricos.

Calculadora de la fórmula del coeficiente Kappa de Cohen

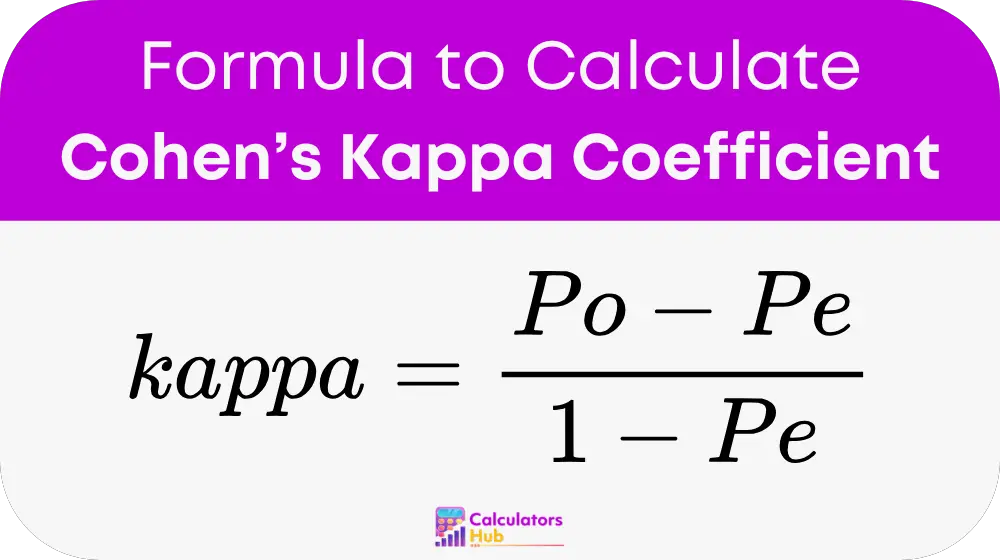

El Kappa de Cohen se calcula utilizando la fórmula:

Lugar:

- Po es la proporción observada de acuerdo entre los evaluadores.

- Pe es la proporción esperada de acuerdo por casualidad.

Fórmulas detalladas:

Acuerdo observado (Po):

Po = Número de acuerdos / Total de observaciones

Acuerdo esperado (Pe):

Pe = Σ (PAi × PBi)

Lugar:

- PAi es la proporción de veces que el evaluador A utilizó la categoría i, calculada como: Número de veces que el evaluador A utilizó la categoría i / Total de observaciones.

- PBi es la proporción de veces que el evaluador B utilizó la categoría i, calculada de manera similar.

Estos cálculos garantizan que el resultado tenga en cuenta la concordancia aleatoria, lo que proporciona una métrica sólida de confiabilidad.

Tabla precalculada para los escenarios Kappa de Cohen

A continuación se muestra una tabla útil que resume los valores Kappa de Cohen precalculados para escenarios comunes, lo que facilita la interpretación de los resultados sin necesidad de realizar cálculos manuales:

| Acuerdo observado (Po) | Acuerdo esperado (Pe) | Kappa (κ) de Cohen | Interpretación |

|---|---|---|---|

| 0.90 | 0.50 | 0.80 | Acuerdo casi perfecto |

| 0.75 | 0.25 | 0.67 | Acuerdo sustancial |

| 0.60 | 0.30 | 0.43 | Acuerdo moderado |

| 0.50 | 0.40 | 0.17 | Ligero acuerdo |

| 0.30 | 0.20 | 0.13 | Ligero acuerdo |

| 0.20 | 0.10 | 0.11 | Mal acuerdo |

Esta tabla puede guiar a los usuarios a comprender rápidamente los niveles de confiabilidad sin realizar cálculos detallados.

Ejemplo de calculadora del coeficiente Kappa de Cohen

Consideremos un ejemplo. Supongamos que dos evaluadores médicos evalúan la presencia de una enfermedad en 100 pacientes. Sus resultados son:

- Evaluador A:Enfermedad detectada en 60 pacientes, ausente en 40.

- Evaluador B:Enfermedad detectada en 55 pacientes, ausente en 45.

De los 100 pacientes, ambos evaluadores coincidieron en 80 (45 con enfermedad presente, 35 ausentes).

Paso 1: Calcular el acuerdo observado (Po)

Po = Número de acuerdos / Total de observaciones

Po = 80 / 100 = 0.80

Paso 2: Calcular el acuerdo esperado (Pe)

La proporción de cada evaluador en cada categoría:

- PA (Enfermedad presente) = 60/100 = 0.60, PA (Enfermedad ausente) = 40/100 = 0.40

- PB (Enfermedad presente) = 55/100 = 0.55, PB (Enfermedad ausente) = 45/100 = 0.45

Pe = (0.60 × 0.55) + (0.40 × 0.45) = 0.33 + 0.18 = 0.51

Paso 3: Calcular Kappa

Kappa = (Po - Pe) / (1 - Pe)

Kappa = (0.80 - 0.51) / (1 - 0.51) = 0.29 / 0.49 ≈ 0.59

Este valor kappa indica un acuerdo moderado entre los evaluadores.

Preguntas frecuentes más comunes

Un valor kappa de 0.60 a 0.80 indica una concordancia sustancial, mientras que los valores superiores a 0.80 representan una concordancia casi perfecta. Los valores inferiores a 0.20 sugieren una concordancia deficiente.

El Kappa de Cohen tiene en cuenta la posibilidad de que el acuerdo se produzca por casualidad, lo que lo convierte en una medida más confiable que el simple acuerdo porcentual.

No, el índice Kappa de Cohen está diseñado para dos evaluadores. Para más de dos evaluadores, se utilizan otras medidas como el índice Kappa de Fleiss.