Esta herramienta especializada ayuda a investigadores y estadísticos al proporcionar una medida estandarizada de acuerdo entre evaluadores más allá del azar. Es particularmente útil en campos como la psicología, la medicina y cualquier investigación que involucre datos de observación.

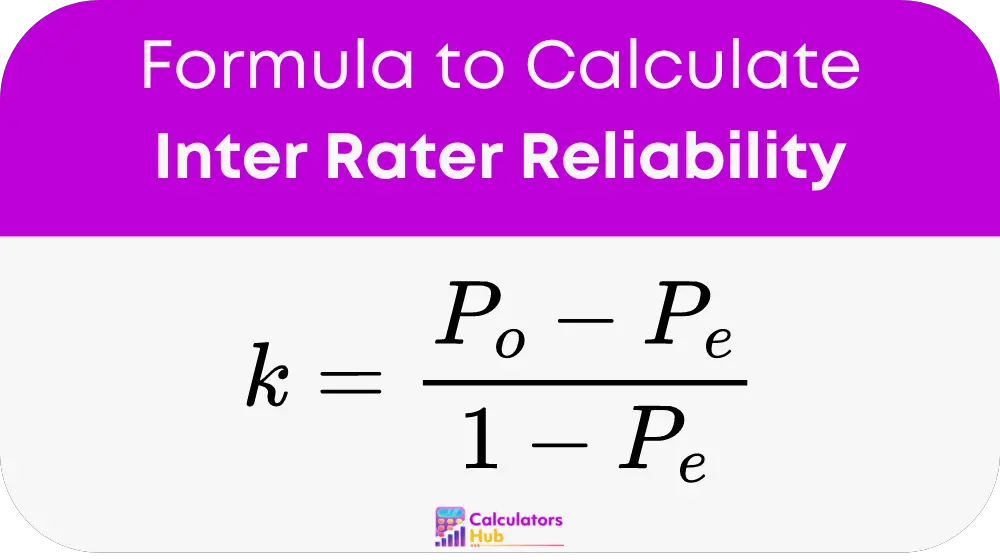

Fórmula de la calculadora de confiabilidad entre evaluadores

La clave La fórmula utilizada para medir la confiabilidad entre evaluadores es el Kappa (k) de Cohen, que cuantifica el nivel de acuerdo entre dos evaluadores. La fórmula es:

Lugar:

- P_o es el acuerdo observado entre los evaluadores.

- P_e es el acuerdo esperado por casualidad.

Guía paso a paso para utilizar la calculadora de confiabilidad entre evaluadores

Construya una tabla de contingencia:

Cree una tabla para registrar diferentes calificaciones asignadas por dos evaluadores. Por ejemplo:

| Calificador B: Sí | Calificador B: No | |

|---|---|---|

| Calificador A: Sí | a | b |

| Calificador A: No | c | d |

Calcular Acuerdo Observado (P_o):

P_o = (a + d) / (a + b + c + d)

Calcular el acuerdo esperado (P_e):

P_e = ((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2

Calcule el Kappa de Cohen:

Usando los valores anteriores, sustitúyalos en la fórmula Kappa de Cohen para obtener el resultado.

Tabla de Términos Generales y Cálculos Relevantes

| Término | Definición |

|---|---|

| Fiabilidad entre | Una medida de cuán consistentemente diferentes evaluadores evalúan los mismos fenómenos. |

| Kappa (k) de Cohen | Estadística que mide la confiabilidad entre evaluadores para elementos categóricos. |

| Acuerdo observado (P_o) | La proporción de veces que los evaluadores están de acuerdo. |

| Acuerdo esperado (P_e) | La probabilidad de que los evaluadores estén de acuerdo por casualidad. |

| Mesa de contingencia | Matriz utilizada para calcular los acuerdos y desacuerdos entre evaluadores. |

Esta tabla proporciona una referencia rápida para comprender los términos y cálculos clave utilizados al evaluar la confiabilidad entre evaluadores, lo que ayuda a comprender el enfoque metodológico de la calculadora de confiabilidad.

Ejemplo de calculadora de confiabilidad entre evaluadores

Escenario:

Dos psicólogos están evaluando a un grupo de pacientes por una condición psicológica específica, donde deben clasificar a cada paciente como "Alto riesgo" o "Bajo riesgo". Después de evaluar a 10 pacientes, registraron sus valoraciones de la siguiente manera:

- Calificador A: Riesgo alto: 5 pacientes, Riesgo bajo: 5 pacientes

- Calificador B: Riesgo alto: 4 pacientes, Riesgo bajo: 6 pacientes

Sus valoraciones son concretamente:

| ID del paciente | Evaluación del evaluador A | Evaluación del evaluador B |

|---|---|---|

| 1 | Alto Riesgo | Alto Riesgo |

| 2 | Riesgo bajo | Riesgo bajo |

| 3 | Alto Riesgo | Riesgo bajo |

| 4 | Riesgo bajo | Riesgo bajo |

| 5 | Alto Riesgo | Alto Riesgo |

| 6 | Riesgo bajo | Alto Riesgo |

| 7 | Alto Riesgo | Alto Riesgo |

| 8 | Riesgo bajo | Riesgo bajo |

| 9 | Alto Riesgo | Riesgo bajo |

| 10 | Riesgo bajo | Riesgo bajo |

Cálculos:

Construya una tabla de contingencia:

| Calificador B: alto riesgo | Calificador B: Riesgo bajo | |

|---|---|---|

| Calificador A: alto riesgo | 3 (a) | 2 (b) |

| Calificador A: Riesgo bajo | 1 (c) | 4(d) |

Calcular Acuerdo Observado (P_o):

P_o = (a + d) / (a + b + c + d) = (3 + 4) / 10 = 0.7

Calcular el acuerdo esperado (P_e):

P_e = [((a + b) * (a + c) + (c + d) * (b + d)) / (a + b + c + d)^2]

= [((3 + 2) * (3 + 1) + (1 + 4) * (2 + 4)) / 10^2]

= [20 + 30] / 100 = 0.5

Calcule el Kappa de Cohen:

k = (P_o – P_e) / (1 – P_e) = (0.7 – 0.5) / (1 – 0.5) = 0.4

Este valor Kappa de Cohen de 0.4 sugiere un acuerdo moderado más allá del azar entre los dos evaluadores.

Preguntas frecuentes más comunes

Mide el acuerdo entre diferentes evaluadores, asegurando que las evaluaciones sean consistentes entre diferentes observadores.

El Kappa de Cohen considera que el acuerdo se produce por casualidad, lo que proporciona una medida de confiabilidad más precisa que el simple acuerdo porcentual.